VAE

1. 自编码器 AutoEncoder

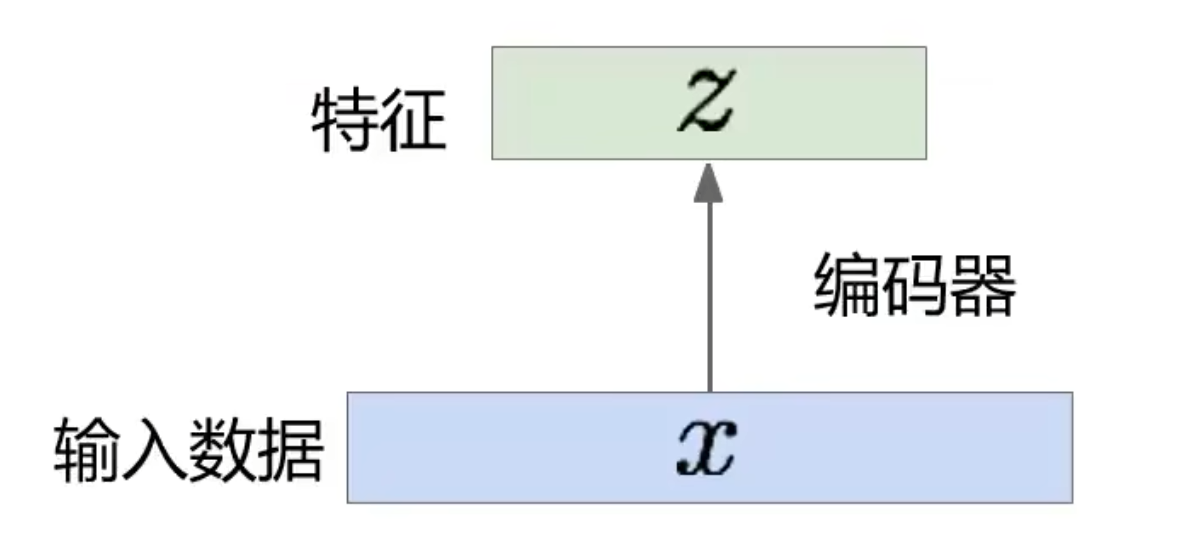

无监督的特征学习,其目标是利用无标签数据找到一个有效的低维的特征提取器:

z 的维度一般小于 x 的维度(特征降维)。

Q: 特征降维有什么用? A: 希望降维后的特征仅保留数据中有意义的信息。

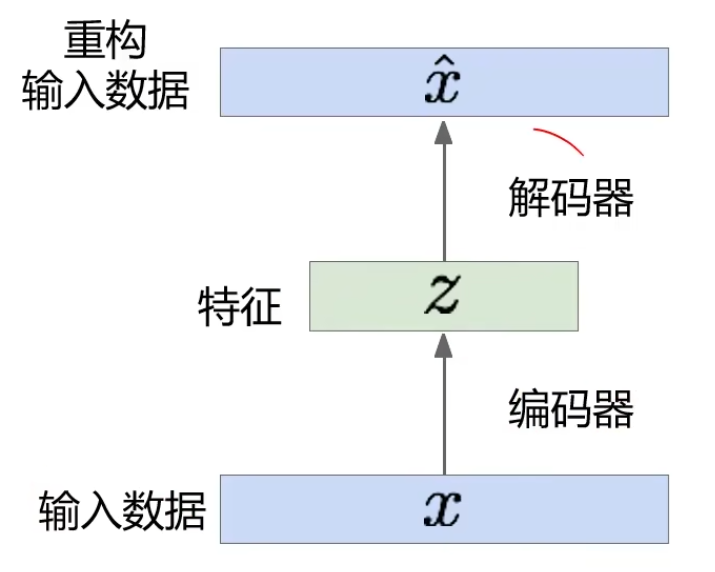

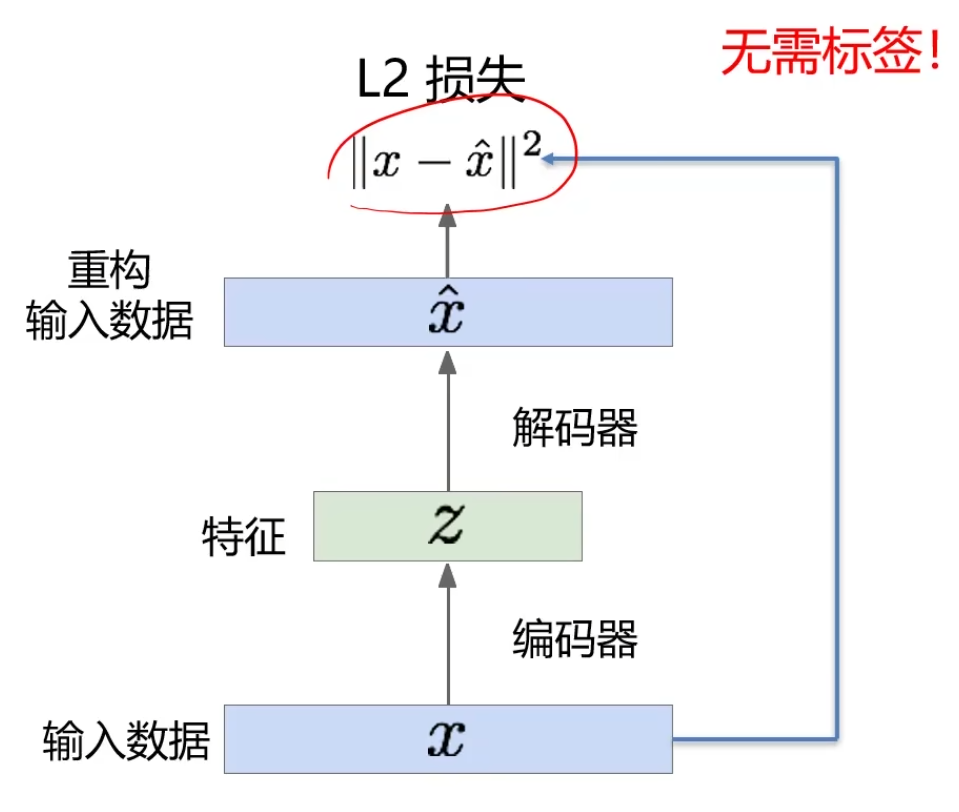

如何学习?

自编码利用重构损失来训练低维的特征表示。

我们希望编码器编出来的特征

把L2损失当做我们监督的信息,将

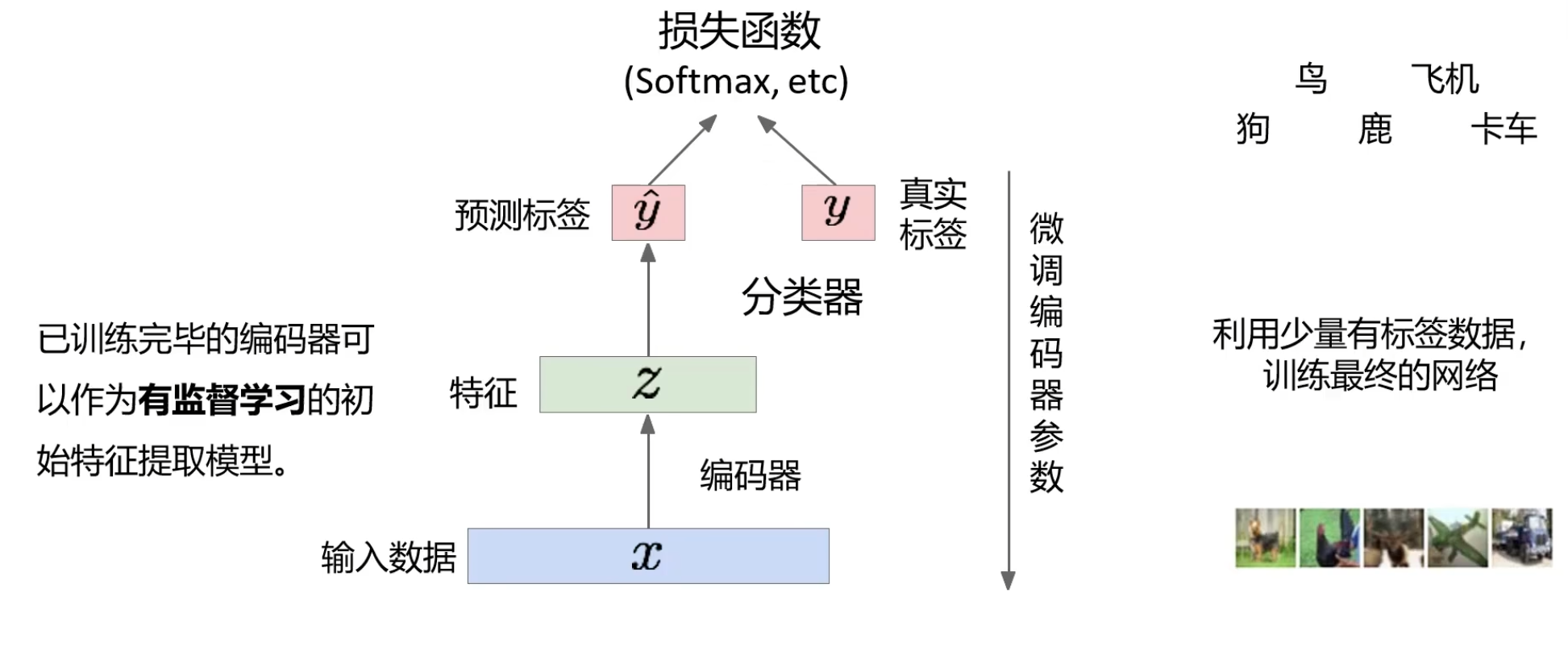

训练后移出解码器,使用

但是事实证明效果一般,因为对于分类任务来说记住所有特征不代表能做好分类。例如,对于人张三和李四的区分点或许就在一个痣,保留的关键特征或许会记住整个人脸,但是不一定会保留痣,而痣恰好是分类的关键。

解码器

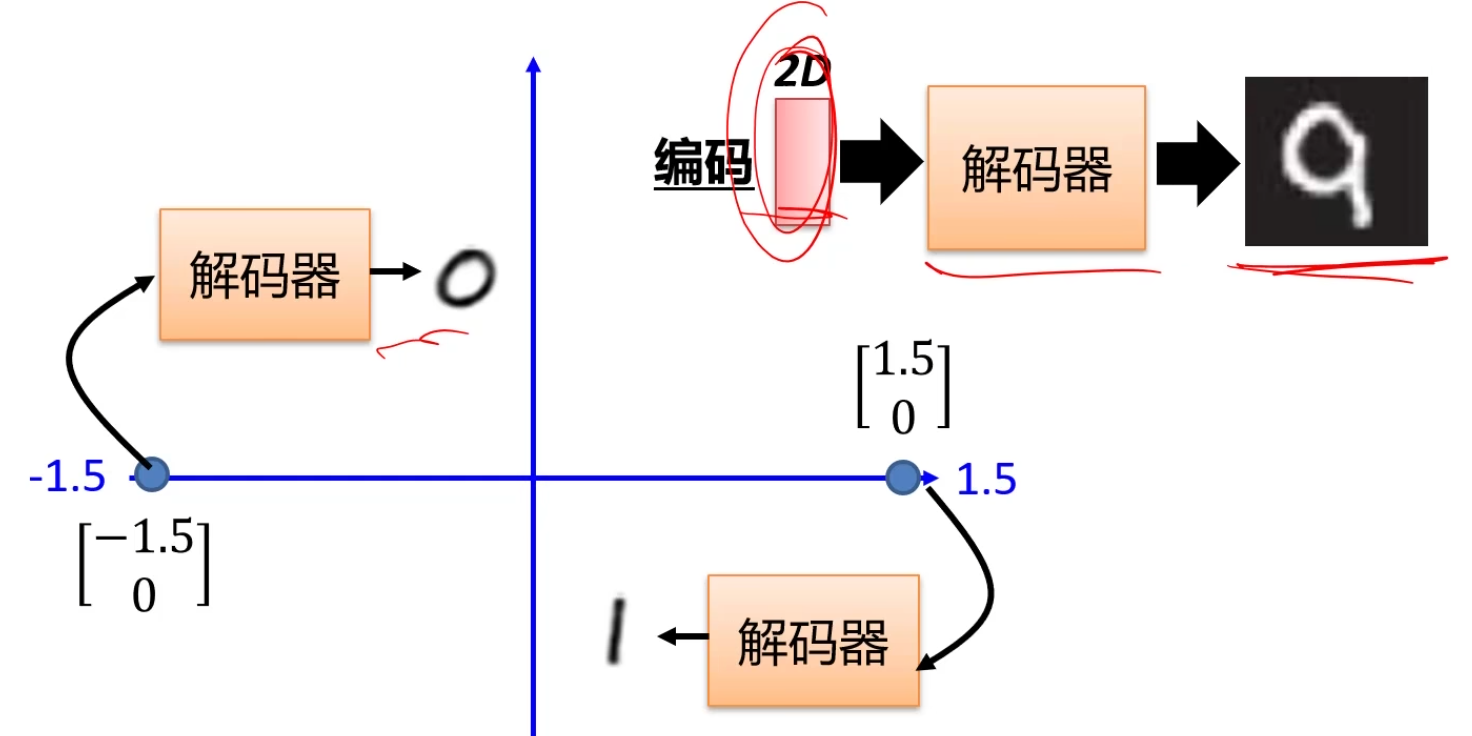

编码器可以用作图像分类任务,而解码器可以用作图像生成:

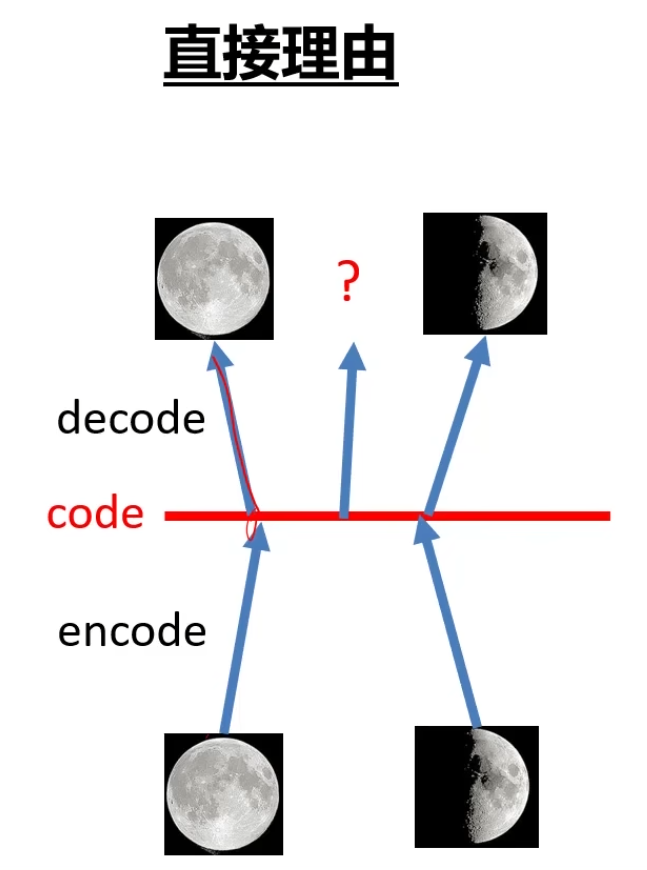

2. 为什么需要 VAE?(变分自编码器 Variational Autoencoders)

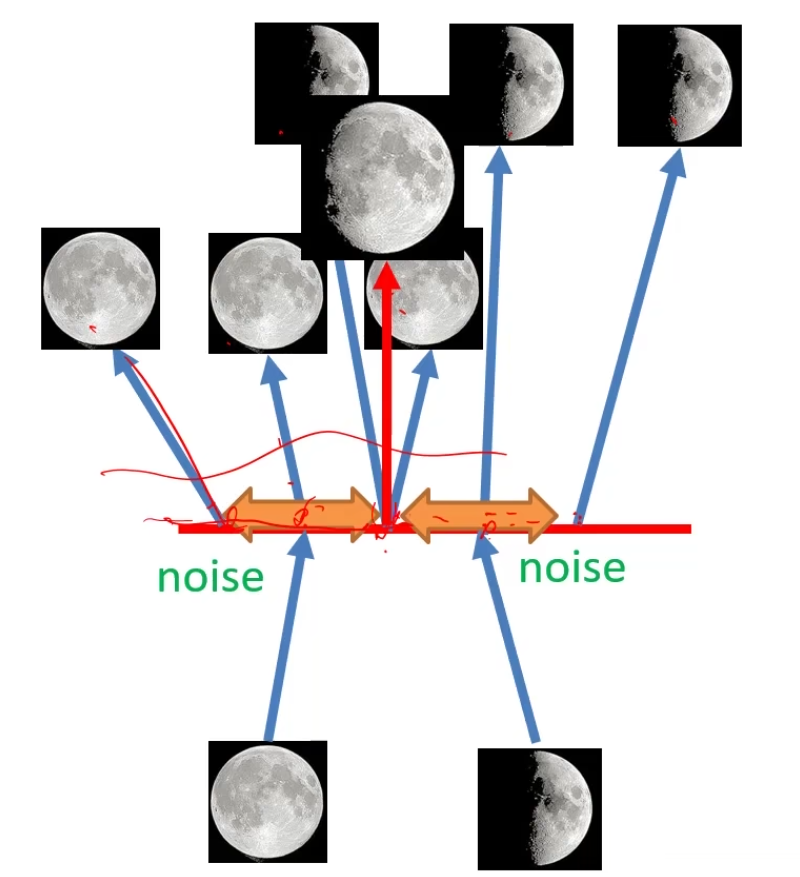

自编码器可以记住码空间的特征关系,但是对于中间部分无法实现。

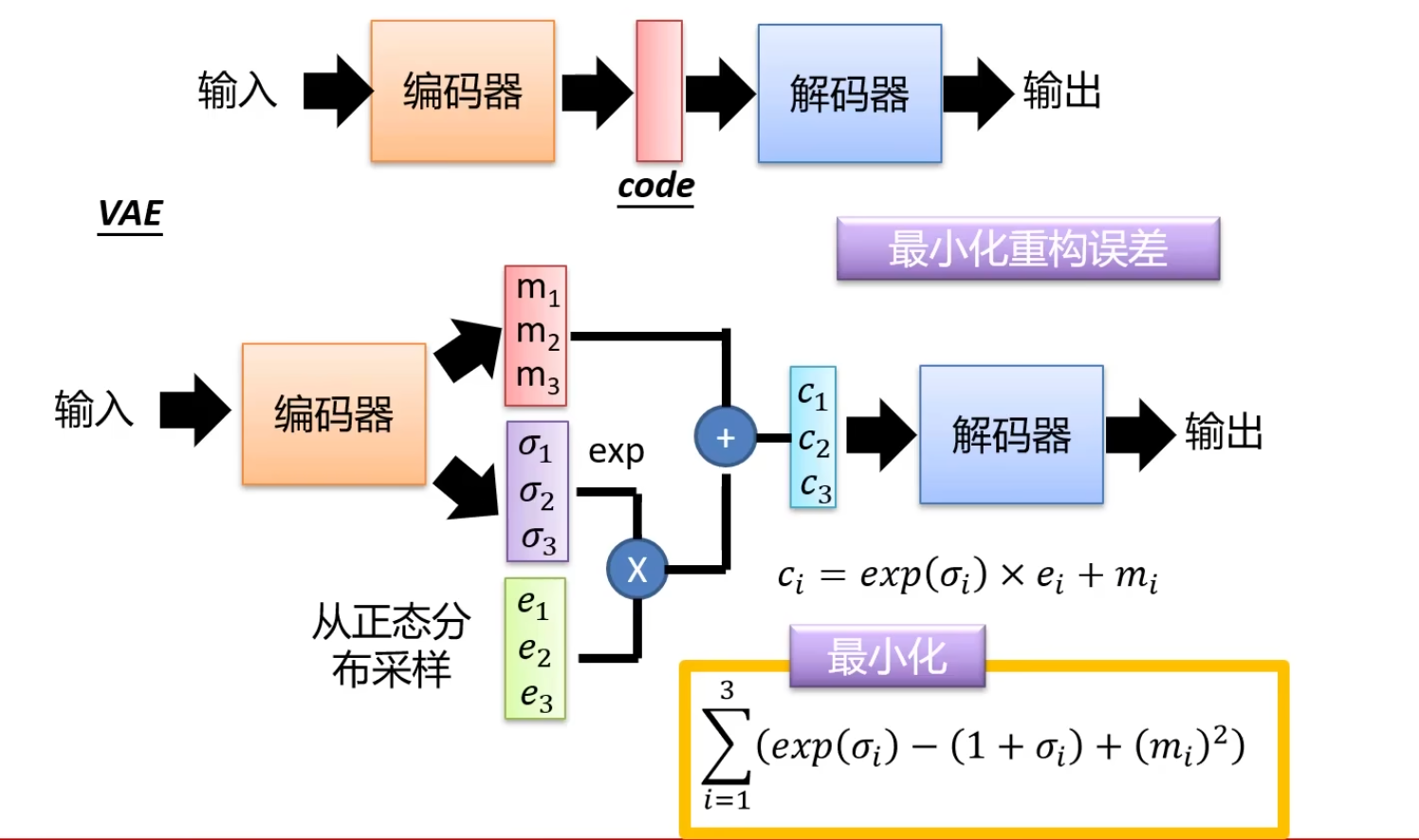

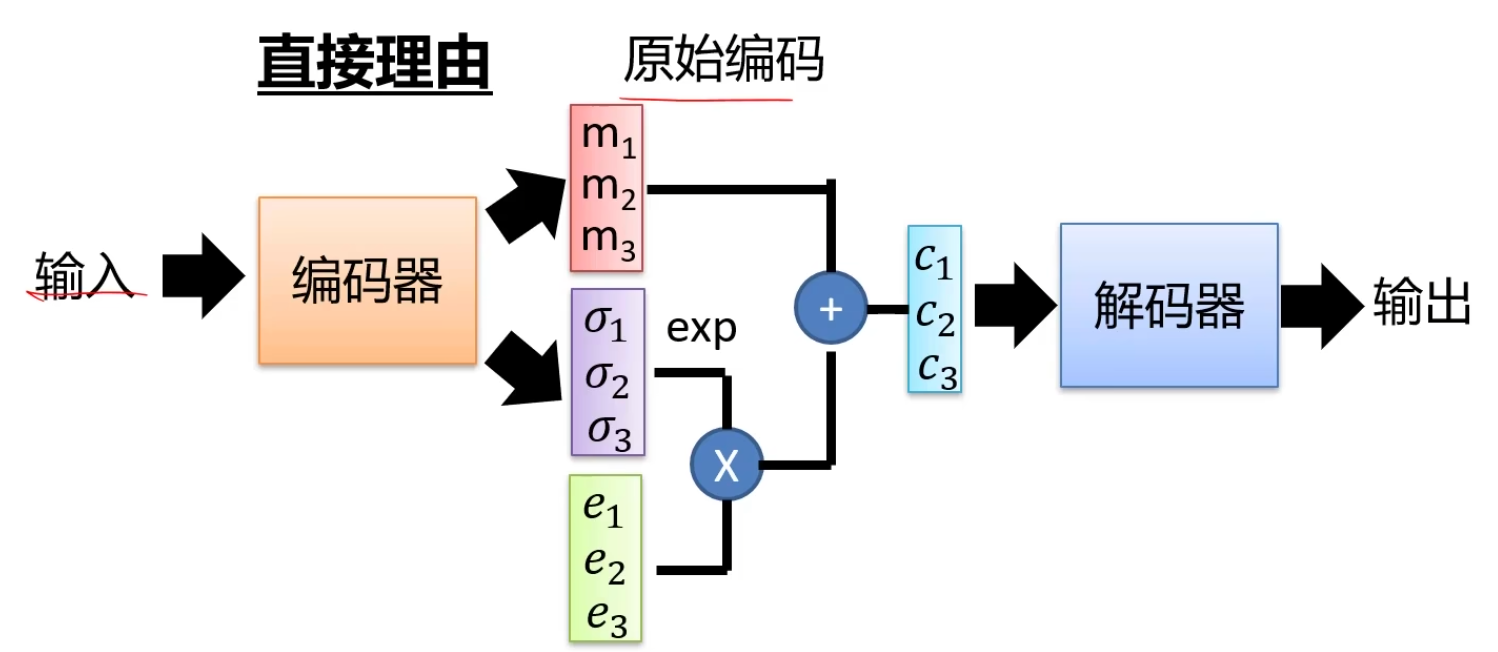

编码器不再输出码

噪声的方差是从数据中学到的,指数次方后一定是个正数,采样: